在网站优化过程中,robots.txt 文件和 网站地图(Sitemap) 配置是 SEO(搜索引擎优化)中非常重要的两个组成部分。它们不仅帮助搜索引擎更好地理解和抓取网站内容,还能有效管理哪些内容应该被爬虫抓取,哪些内容不应被抓取。本文将详细介绍 robots.txt 文件和 Sitemap 的作用、配置方法及最佳实践。

一、Robots.txt 文件介绍

Robots.txt 是一个文本文件,通常位于网站根目录下,用来告知搜索引擎爬虫哪些页面可以被抓取,哪些页面不能被抓取。这个文件通过控制爬虫的访问,帮助站长管理搜索引擎如何索引他们的网站内容。

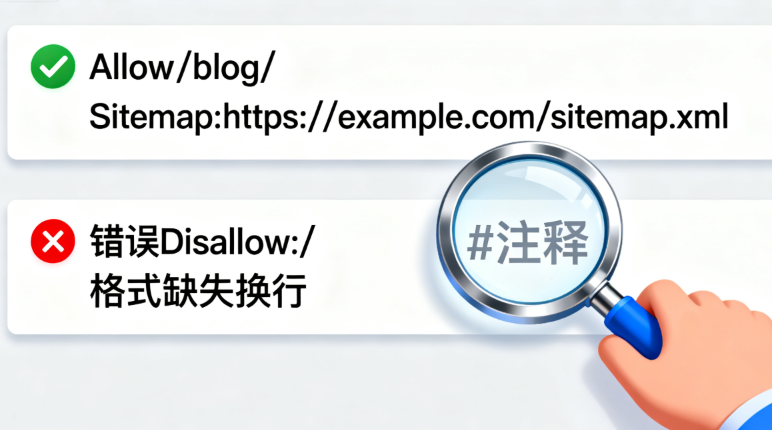

1.1 Robots.txt 文件的基本结构

一个典型的 robots.txt 文件由 User-agent 和 Disallow 或 Allow 等指令组成:

User-agent: [爬虫名称] Disallow: [禁止抓取的路径] Allow: [允许抓取的路径]

User-agent:指定要遵循规则的搜索引擎爬虫(如

Googlebot、Bingbot)。如果为*,表示所有爬虫都会遵循这个规则。Disallow:指示爬虫不要抓取指定路径。

Allow:指示爬虫可以抓取指定路径。

示例:

User-agent: * Disallow: /private/ Disallow: /admin/ Allow: /public/

这意味着所有的爬虫都不允许抓取 /private/ 和 /admin/ 文件夹,但允许抓取 /public/ 文件夹。

1.2 常用的 Robots.txt 指令

User-agent: 指定适用于特定爬虫的规则,例如Googlebot(Google的爬虫)或Bingbot(Bing的爬虫)。Disallow: 指定不允许爬虫访问的路径或文件。Allow: 允许访问某些路径,特别是当有更广泛的Disallow规则时。Sitemap: 指定网站地图的 URL 地址,帮助搜索引擎找到站点的结构和页面。

示例:

User-agent: * Disallow: /private/ Sitemap: https://www.example.com/sitemap.xml

这个配置告知所有爬虫不抓取 /private/ 文件夹,并提供了网站地图的链接,帮助爬虫更好地理解站点的结构。

1.3 常见问题和误区

禁止所有爬虫抓取:

User-agent: * Disallow: /

这种设置会禁止所有爬虫抓取整个网站。若错误配置,可能导致网站完全不被搜索引擎收录。

使用

robots.txt限制不必要的内容:可以通过robots.txt阻止爬虫抓取特定的后台页面、管理页面或不需要索引的文件,避免浪费搜索引擎资源。

二、网站地图(Sitemap)介绍

网站地图(Sitemap) 是一种列出网站所有页面的文件,帮助搜索引擎更高效地抓取网站内容。网站地图可以是 XML 格式、HTML 格式,甚至是图像地图或视频地图。最常用的是 XML Sitemap,它通过 XML 文件列出了网站中所有的 URL 地址,并提供有关每个页面的附加信息(如更新频率、最后更新时间等)。

2.1 Sitemap 文件的作用

提高抓取效率:搜索引擎使用网站地图了解网站的结构和重要页面,提高抓取的效率。

确保页面被抓取:即使某些页面的内部链接较少,使用网站地图可以确保搜索引擎能够找到它们。

优化大站点的索引:对于大型网站,包含成千上万的页面,网站地图非常有助于确保所有页面都能被索引。

2.2 XML 网站地图的基本结构

XML 网站地图通常是一个包含 <urlset> 元素和 <url> 子元素的文件。每个 <url> 元素代表一个页面,并且可以包含一些有用的元数据:

<?xml version="1.0" encoding="UTF-8"?> <urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9"> <url> <loc>https://www.example.com/</loc> <lastmod>2025-09-01</lastmod> <changefreq>daily</changefreq> <priority>1.00</priority> </url> <url> <loc>https://www.example.com/contact</loc> <lastmod>2025-09-02</lastmod> <changefreq>monthly</changefreq> <priority>0.80</priority> </url> </urlset>

<loc>:页面的完整 URL 地址。<lastmod>:页面最后更新时间。<changefreq>:页面更新频率,如daily、weekly、monthly等。<priority>:页面的优先级,值在 0.0 到 1.0 之间,1.0 表示最高优先级。

2.3 如何生成和提交网站地图

手动生成网站地图:对于较小的网站,可以手动创建 XML 文件,列出所有 URL。

自动生成工具:使用网站地图生成器工具(如 Yoast SEO 插件、Screaming Frog 等)自动生成网站地图。

提交到搜索引擎:生成并上传网站地图后,可以通过 Google Search Console 或 Bing Webmaster Tools 提交网站地图,让搜索引擎知道如何抓取你的站点。

三、Robots.txt 与 Sitemap 配置最佳实践

3.1 Robots.txt 中配置 Sitemap

在 robots.txt 文件中正确配置网站地图 URL 是确保搜索引擎能够找到并抓取网站地图的关键。这个配置通常放在文件的末尾:

Sitemap: https://www.example.com/sitemap.xml

3.2 管理网站的抓取权限

避免不必要的资源被抓取:确保

robots.txt中的Disallow规则指向不需要被抓取的内容,例如后台管理页面、登录页面、个人隐私数据等。利用 Sitemap 指定重要页面:确保网站地图中包含最重要的页面,尤其是那些没有很多内部链接的页面,帮助搜索引擎尽可能全面地抓取你的内容。

3.3 定期更新网站地图

当你更新或添加新的页面时,记得更新网站地图,特别是在大型网站中,这有助于搜索引擎更快地抓取和索引新内容。

如果你经常更新内容,考虑通过工具(如 Google Search Console)查看站点的抓取状态,确保所有重要页面都能及时更新和收录。

四、常见问题解答

4.1 我能否通过 robots.txt 禁止 Google 抓取某些页面,但仍希望它们出现在搜索结果中?

如果你通过

robots.txt阻止了某些页面的抓取,搜索引擎将无法读取这些页面的内容,因此这些页面将不会出现在搜索结果中。若要让页面出现在搜索结果中,你需要确保它们可以被抓取。

4.2 我的 robots.txt 文件会影响 SEO 吗?

会,错误的

robots.txt配置可能会导致某些页面无法被抓取,从而影响搜索引擎对该页面的索引和排名。确保在配置时仔细检查。

4.3 是否所有网站都需要 robots.txt 文件?

对于大多数网站,

robots.txt文件是有用的,尤其是在管理哪些页面可以被抓取时。但是,如果你的网站内容完全公开且不需要限制任何内容,可以选择不使用robots.txt文件。

总结

Robots.txt 文件 和 网站地图(Sitemap) 是网站管理和搜索引擎优化中的关键工具。robots.txt 让站长能够控制哪些内容可以被抓取,哪些内容不应该被抓取,从而帮助搜索引擎更高效地索引网站。而网站地图则提供了网站结构的清晰视图,确保搜索引擎能够及时抓取和更新网站中的重要页面。

合理配置这两个工具,将大大提高网站的搜索引擎友好度,有助于提升网站的 SEO 排名和用户体验。

热门文章