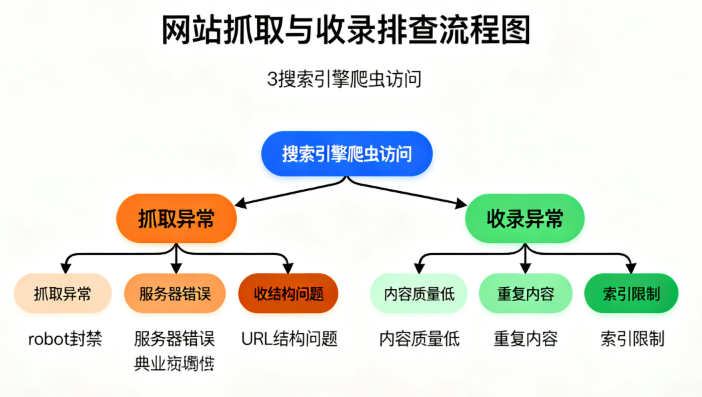

网站抓取与收录问题是影响SEO(搜索引擎优化)和网站流量的重要因素。如果你发现网站的抓取或收录存在问题,可以按照以下步骤进行排查:

1. 检查 robots.txt 文件

作用:

robots.txt文件控制搜索引擎的爬虫访问哪些页面或部分内容。排查:

常见问题:

User-agent: * Disallow: /

这意味着所有爬虫都被阻止抓取整个网站。

确保没有阻止重要页面的抓取。

查找是否有

Disallow指令阻止了搜索引擎爬取重要资源(如JavaScript文件、CSS文件等)。使用 Google Search Console 中的 抓取分析工具,检查是否有错误提示。

2. 检查页面的 Meta Robots 标签

作用:

meta robots标签控制单个页面的索引和链接跟踪设置。排查:

常见错误:

<meta name="robots" content="noindex, nofollow">

这种标签会阻止该页面被搜索引擎索引和跟踪。

检查是否有页面使用了

noindex或nofollow标签,导致这些页面无法被收录。确保没有在页面上错误地加入

noindex标签。

3. 查看网站的抓取频率

作用:如果网站更新频繁或者有大量内容需要抓取,搜索引擎可能需要更多时间进行索引。

排查:

通过 Google Search Console 查看抓取频率和抓取错误。

检查 服务器性能,如果网站响应速度过慢,可能会影响爬虫的抓取效率。

4. 使用 Google Search Console 的“抓取错误”报告

作用:通过 Google Search Console 检查网站的抓取错误,查看哪些页面存在抓取问题。

排查:

打开 Google Search Console,进入 覆盖率 报告(Coverage)。

检查报告中的 抓取错误,并解决相关问题(如 404 错误、403 错误等)。

如果是 404 错误,可以通过重定向或恢复页面来解决。

常见错误:

404 错误:页面不存在。

403 错误:访问被拒绝,可能由于服务器配置问题或权限设置问题。

5xx 错误:服务器问题,通常是临时的,检查服务器日志。

5. 检查网站的 URL 结构

作用:URL结构不合理或过于复杂可能导致搜索引擎难以抓取。

排查:

常见问题:

example.com/page.php?id=12345这种URL比example.com/page-name更难以抓取。确保URL简洁、清晰,避免使用过长、难以理解的参数或动态URL。

使用 静态URL,避免复杂的查询字符串。

6. 检查是否有重定向问题

作用:重定向问题(如301重定向、302重定向)可能导致页面无法被正常抓取或索引。

排查:

使用 Screaming Frog 或 Ahrefs 等工具检查是否存在循环重定向或不必要的重定向。

检查是否有 301永久重定向 错误的页面。比如,新网站迁移时,确保旧链接正确重定向到新页面。

7. 检查页面加载速度

作用:页面加载速度慢可能导致搜索引擎爬虫抓取过程中超时或无法抓取。

排查:

使用 Google PageSpeed Insights 或 GTmetrix 检查页面加载速度,查看是否有优化空间。

提升网页的加载速度,减少大型图片文件,启用浏览器缓存等。

8. 检查是否有重复内容问题

作用:重复内容可能导致搜索引擎无法判断优先索引哪个页面,可能会影响收录。

排查:

常见问题:

<link rel="canonical" href="https://www.example.com/original-page">

这样可以告诉搜索引擎哪个页面是原始版本,避免重复内容。

确保每个页面都是独一无二的,避免内容重复。

使用 canonical 标签 指明优先的页面版本。

9. 检查是否有搜索引擎惩罚

作用:如果网站违反了搜索引擎的规则,可能会被惩罚,导致抓取或收录问题。

排查:

查看 Google Search Console 中的 手动操作 报告,检查是否有因违反 Google 的质量指南而被处罚。

如果受到惩罚,需要根据提示纠正问题,并向 Google 提交复审请求。

10. 查看站点地图(Sitemap)

作用:站点地图帮助搜索引擎更高效地抓取网站。

排查:

常见问题:

如果站点地图没有更新或包含无效链接,搜索引擎可能无法抓取新页面。确保网站提交了正确的 XML 站点地图。

在 Google Search Console 中检查站点地图的提交状态,确保没有错误。

11. 检查是否有 CAPTCHA 或防火墙限制

作用:有时为了防止恶意爬虫,网站会使用 CAPTCHA 或防火墙限制爬虫抓取。

排查:

检查是否有防火墙或验证码系统阻止了爬虫访问。

确保爬虫可以正常访问重要的页面和资源。

总结:

通过上述的排查步骤,你可以识别并解决网站抓取和收录过程中可能遇到的问题。保持网站结构清晰、内容质量高,并关注技术SEO,能有效提高网站的抓取和收录效率。如果问题持续存在,可以考虑寻求专业的SEO技术支持。

热门文章