在现代互联网的日常使用中,搜索引擎扮演着至关重要的角se。无论是通过 Google、Bing、Yahoo 还是其他搜索引擎,用户可以快速获得各种信息。然而,很多人并不清楚搜索引擎是如何工作的。本文将深入探讨搜索引擎的工作原理,帮助你更好地理解其背后的机制,进而优化网站,提高搜索引擎的可见性。

一、搜索引擎的基本结构

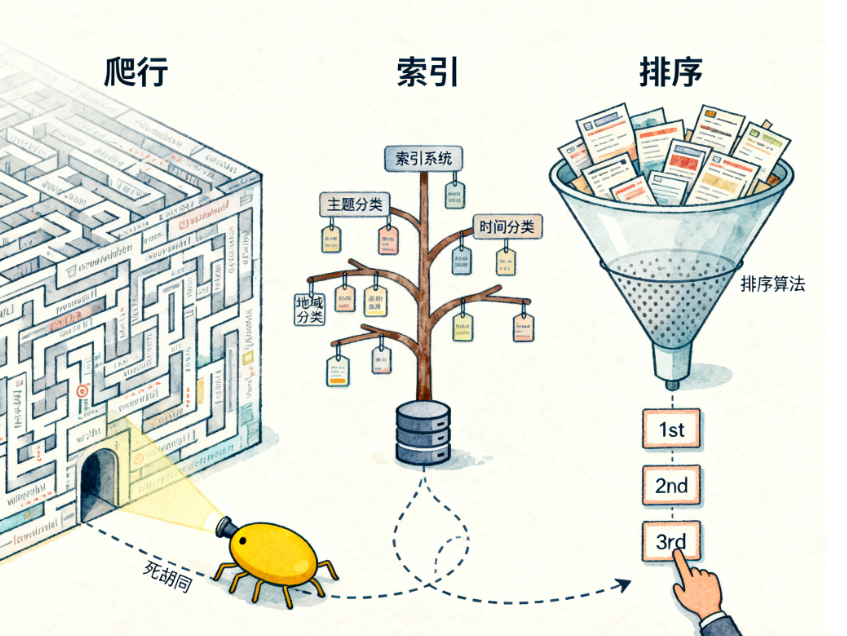

搜索引擎的基本工作流程通常可以分为三个主要步骤:爬虫(Crawling)、索引(Indexing)和排名(Ranking)。这三个过程相互配合,共同决定了搜索引擎结果页面(SERP)的展示顺序。

1.1 爬虫(Crawling)

爬虫(也叫蜘蛛、机器人或网络爬虫)是搜索引擎的首要部分,负责扫描并访问网页,收集网页的内容和信息。

如何工作:爬虫通过访问网页上的链接来发现新页面。每次它访问一个网站时,都会记录页面的内容、结构和各类信息(如文本、图片、视频等)。爬虫会跟踪网站内部的链接,继续爬取下一个网页,直到访问到所有需要的信息。

URL的作用:爬虫会依赖网页中的URL结构,遍历所有网页。在网页上所设置的内部链接(Internal Links)和外部链接(External Links)可以帮助爬虫发现更多页面。

robots.txt文件:网站的

robots.txt文件告诉搜索引擎爬虫哪些页面可以访问,哪些页面不允许访问。网站管理员可以通过该文件控制爬虫的行为,避免不必要的页面被爬取。

1.2 索引(Indexing)

当爬虫收集到一个网页的数据后,搜索引擎并不会立即在搜索结果中显示它,而是将网页内容存储在一个称为索引的数据库中。

什么是索引?:索引是一个庞大的数据结构,像是搜索引擎的大型数据库,它包含了所有已爬取网页的内容。索引帮助搜索引擎快速检索相关信息,以便在用户搜索时迅速返回相关结果。

如何建立索引:搜索引擎会分析网页的各种元素,如标题、正文内容、关键词、图片alt标签等,并将这些信息存储在索引中。通过对页面的内容进行分类和组织,搜索引擎能够更精确地找到用户搜索的相关页面。

结构化数据:为了更好地理解网页内容,网站通常会使用结构化数据(如 Schema.org)标记页面信息。这有助于搜索引擎更清楚地理解内容,提升索引的质量。

1.3 排名(Ranking)

一旦搜索引擎的数据库中有了相关的网页索引,它就能根据用户的查询返回最相关的结果。这个过程就是排名(Ranking)。排名的目的是确保搜索引擎在用户输入查询时,能够提供最有用、最相关的网页。

排名算法:搜索引擎使用复杂的算法来决定如何对结果进行排序。这些算法会考虑多个因素,包括网页内容的相关性、用户的搜索意图、网页的质量、外部链接的数量和质量等。

重要排名因素:

关键词匹配:搜索引擎会根据用户的搜索关键词与网页内容的匹配程度来评估相关性。页面中出现关键词的频率、位置和使用情况(如标题、meta标签等)都能影响排名。

页面质量:高质量的内容通常会获得较高的排名。搜索引擎会分析页面是否具有原创性、是否提供有价值的信息等。

反向链接(Backlinks):网页的外部链接数量和质量是排名的关键因素之一。一个页面如果获得了多个高质量网站的链接,会被认为该页面具有较高的权威性,进而提升其排名。

用户体验:搜索引擎越来越注重页面的用户体验(UX),例如页面加载速度、移动端适配、页面设计的易用性等,都会影响排名。

二、搜索引擎的算法

搜索引擎的排名算法决定了网页在搜索结果中的展示顺序。虽然不同的搜索引擎使用不同的算法,但其核心目标始终是为用户提供最相关和有价值的内容。以下是几个关键的算法:

2.1 Google的PageRank

PageRank 是谷歌最初使用的一种算法,通过评估网页的反向链接来判断该页面的重要性和相关性。PageRank将一个网页的权威性与其他网页对它的链接关系紧密结合,认为越多高质量网站链接到该页面,它的权威性和相关性就越高。

2.2 用户意图和语义搜索

随着技术的进步,搜索引擎已经不仅仅依赖于简单的关键词匹配。现代搜索引擎开始通过语义搜索理解用户的搜索意图,例如自然语言处理(NLP),通过分析用户查询背后的含义来提供更精确的结果。

示例:当用户搜索“如何做蛋糕?”时,搜索引擎会理解用户是想获得有关蛋糕制作的教程或食谱,而不仅仅是返回含有“蛋糕”和“做法”字眼的网页。

2.3 机器学习与人工智能

现在的搜索引擎,特别是谷歌,已经广泛采用了机器学习和人工智能技术,如RankBrain和BERT,来优化搜索结果。通过这些技术,搜索引擎能够更好地理解复杂的查询、用户的偏好、以及内容的上下文,从而提升搜索质量。

三、搜索引擎的更新与优化

搜索引擎在不断更新其算法,以应对新的互联网环境和用户需求。这些更新通常会影响网页的排名,促使网站管理员不断进行优化。

算法更新:谷歌每年都会进行数百次算法更新。常见的更新包括核心算法更新、质量评分更新、反向链接算法更新等。网站优化者需要持续关注这些更新,以调整自己的SEO策略。

核心算法更新:如Google的“Panda”和“Penguin”更新,分别关注内容质量和链接质量,促使网站更加注重原创、高质量的内容和健康的链接建设。

E-A-T原则:近年来,Google越来越重视网站的E-A-T(专业性、权威性和可信度)。对于医疗、金融等敏感领域的网站,尤其要求页面具备高权威性,相关内容必须经过认证。

四、总结

搜索引擎通过爬虫抓取、索引网页数据,并根据排名算法返回最相关的搜索结果。在这个过程中,SEO(搜索引擎优化)是优化网站内容、结构和外链的重要手段,以提升网站在搜索引擎中的可见性。随着搜索引擎技术的不断进化,特别是语义搜索和人工智能的应用,搜索引擎的工作原理越来越复杂,但它们的核心目标始终是为用户提供最优质和最相关的信息。因此,了解搜索引擎的工作原理不仅有助于我们制定有效的SEO策略,还能帮助我们更好地优化网站内容,提升用户体验。

热门文章

- LinkedIn 聚光灯广告(Spotlight Ads)规范详解:动态广告素材与投放指南

- LinkedIn 动态职位广告规范详解:格式要求与投放注意事项

- LinkedIn Ads 常见数据问题分析:广告投放指标异常与解决方法

- LinkedIn Ads 广告规范完整指南:素材要求、格式标准与投放规则

- LinkedIn 动态关注者广告规范详解:Follower Ads 投放与素材要求

- LinkedIn Ads 广告费用是多少?完整成本解析(2026)

- 《LinkedIn Ads 广告素材尺寸大全(2026最完整版本)》

- 外贸人必备:全球港口代码查询大全(附官网查询入口)

- 多内容展示营销指南:LinkedIn 轮播广告(Carousel Ads)规范

- B2B精准沟通策略:LinkedIn Conversation Ads 使用教程